WOW! Tesla full self driving dodges a freaking plane falling out of the sky! @Tesla fsd for the win! @elonmusk

Le média n'a pas pu être lu.

Un avion qui tombe, un crash évité, des millions de vues et une pluie de compliments : la dernière vidéo autour de Tesla a enflammé les réseaux et relancé le fantasme de la conduite autonome. Sauf que derrière le storytelling, la réalité est simple : la prouesse est 100% humaine, pas logicielle. Décryptage d’une légende virale qui confond marketing et science-fiction.

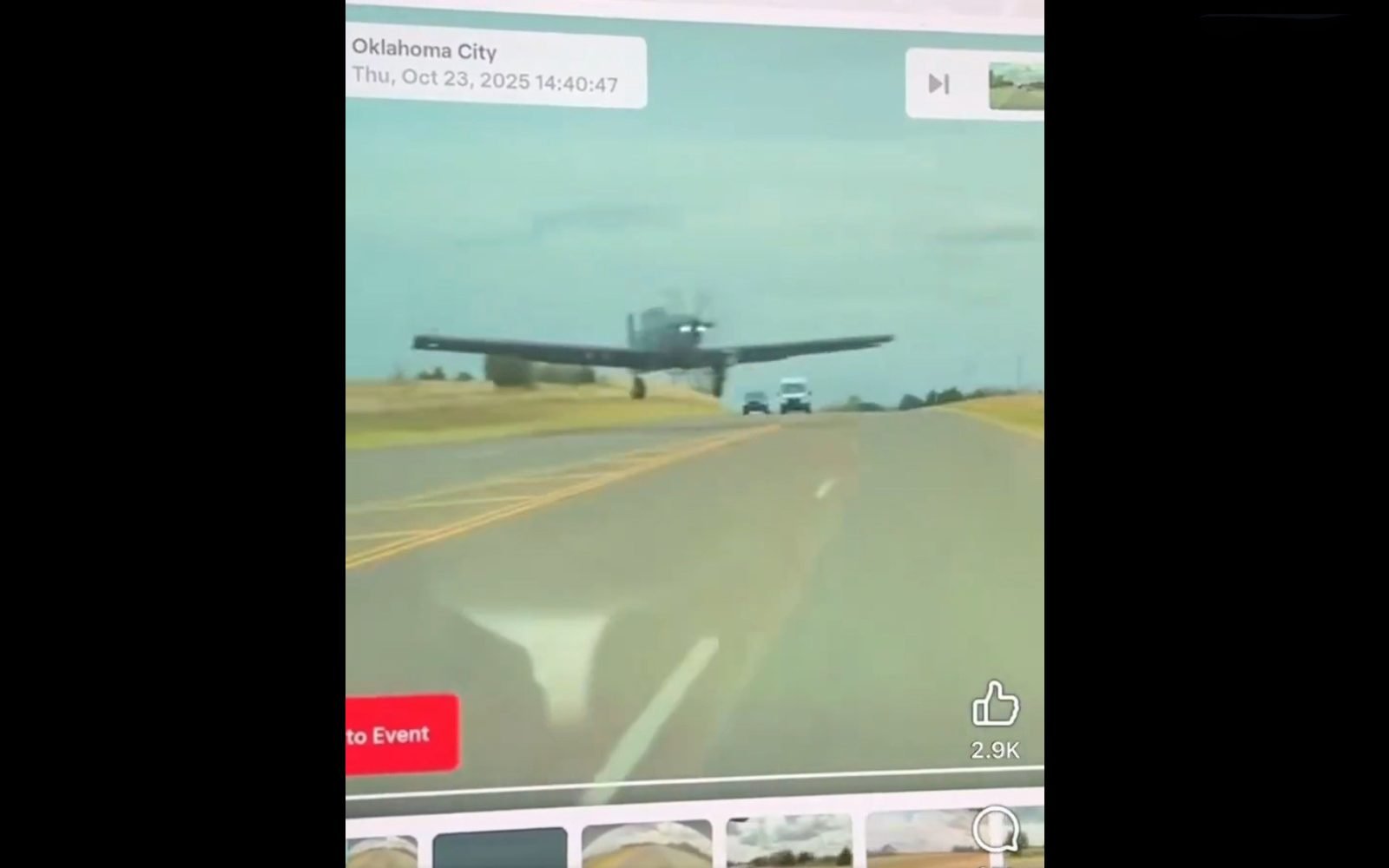

Depuis peu, une vidéo impressionnante circule : sur une route d’Oklahoma City, un avion militaire rate son atterrissage et manque de faucher la circulation. Une Tesla arrive, esquive l’impact au dernier moment, et la scène est captée par la dashcam du véhicule. En quelques heures, l’extrait explose : fans de la marque, influenceurs et même la mère d’Elon Musk s’enflamment, attribuant l’exploit au « Full Self-Driving ». La voiture autonome aurait, dit-on, sauvé des vies à la place du conducteur.

La vérité, elle, est limpide. Le propriétaire de la Tesla, Matthew Topchian, contredit le récit : l’évitement a été réalisé en conduite manuelle, sans Autopilot. « Le système est bon, mais il aurait percuté cet avion », explique-t-il sur TikTok, face à des milliers d’internautes convaincus que Tesla a signé une manœuvre autonome magique. Malgré ses clarifications, la légende continue de tourner : des comptes pro-Tesla sur X, Maye Musk et même des comptes russes repartagent la séquence en boucle. Les rectificatifs se perdent dans le bruit : la confusion entre assistance, autonomie réelle et réflexe humain brouille encore plus les repères.

Depuis des années, Tesla alimente l’image d’une voiture quasi autonome, renforcée par une communication récurrente sur les « super pouvoirs » du FSD et de l’Autopilot. Officiellement, le conducteur reste responsable ; officieusement, la confusion prospère : entre promesse d’« intelligence sur roues » et discours rassurant sur la sécurité, marketing et éléments de langage entretiennent une surconfiance. Conséquence lourde : côté tribunaux, la responsabilité des accidents évolue. Après avoir longtemps renvoyé la faute vers les conducteurs, Tesla a perdu des procès en 2025, et s’est vu reconnaître une part de responsabilité dans un accident mortel avec Autopilot activé.

WOW! Tesla full self driving dodges a freaking plane falling out of the sky! @Tesla fsd for the win! @elonmusk

Le média n'a pas pu être lu.

En parallèle, Tesla multiplie les règlements à l’amiable et fait face à des class actions grandissantes : en Californie et en Australie, des juges estiment que la marque a survendu les capacités réelles de ses véhicules et induit les acheteurs en erreur sur la promesse d’une vraie autonomie. Cette surenchère marketing, rarement corrigée malgré les rappels des autorités, renforce l’illusion d’un système infaillible. Or, FSD et Autopilot restent des aides de niveau 2 : la vigilance du conducteur est indispensable, et les capteurs comme les algorithmes sont encore loin de l’autonomie annoncée depuis 2016. Dernière illustration : le constructeur a mis en avant un mode nommé « Mad Max » pour pousser son système à des décisions plus offensives, quitte à dépasser parfois les limitations de vitesse.

Au fond, l’incident évité par Matthew Topchian résume le malaise : une techno bluffante, trop souvent parée de pouvoirs qu’elle n’a pas. Tant que la communication et les rapports d’incidents ne seront pas plus explicites, cette surconfiance exposera les conducteurs à des risques évitables et les marques à des retours de bâton juridiques. Ailleurs, la Chine a déjà serré la vis : les autorités demandent aux constructeurs de cesser d’employer abusivement le terme « conduite autonome », après un accident mortel impliquant des étudiantes et une Xiaomi SU7. Pour que l’assistance à la conduite serve vraiment la sécurité routière, il faut cesser de confondre miracle technologique, storytelling et responsabilité humaine. Au volant, rien ne remplace le discernement d’un conducteur attentif.

Au-delà du storytelling, rester maître à bord passe aussi par le choix de sa mobilité: en LOA/LLD, un Volvo XC90 marie sécurité et raison. Pour un leasing clair, avec garanties et achat à distance, voyez Joinsteer.

De l'achat, à la revente, au financement, en passant par les derniers projets de loi automobile, Voiture Malin est la référence de l'info automobile